Somos una Fundación que ejercemos el periodismo en abierto, sin muros de pago. Pero no podemos hacerlo solos, como explicamos en este editorial.

¡Clica aquí y ayúdanos!

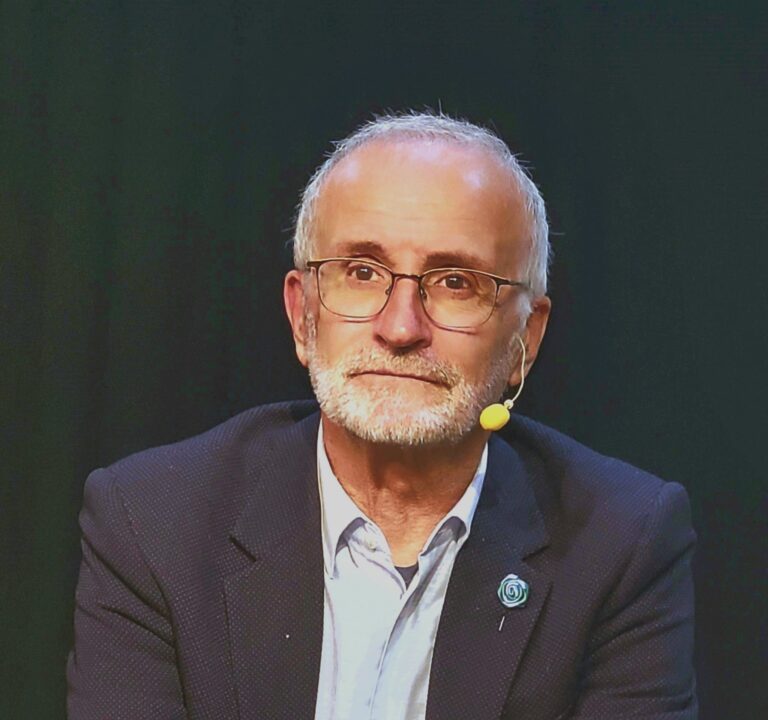

Ramon López de Mántaras i Badia (Sant Vicenç de Castellet, Bages, 1952) es profesor (emérito) de investigación del CSIC en el Instituto de Investigación en Inteligencia Artificial (IIIA), del cual fue director; miembro del Institut d’Estudis Catalans, miembro de honor de la Asociación Europea de Inteligencia Artificial y forma parte de distintos comités asesores para instituciones públicas y empresas americanas y europeas sobre temas relacionados con la IA. Es el autor de “100 coses que cal saber sobre intel·ligència artificial” (Ed. Cossetània)

En el libro comenta que la comprensión del lenguaje y los conocimientos de sentido común son los principales problemas que afronta la inteligencia artificial.

Sí. Desde el punto de vista científico, creo que si queremos tener una inteligencia artificial que sea realmente más inteligente que la que tenemos ahora, que todavía es muy limitada, es necesario que entienda el mundo y que tenga conocimientos sobre cómo funciona. Y una parte de estos conocimientos son los conocimientos de sentido común: predecir los resultados de tus acciones, saber explicar lo que ves y entender el lenguaje, porque el lenguaje no se entiende si no tienes referentes del mundo que te rodea y que experimentamos desde que somos pequeñitos… Un software de un ordenador no tiene interacción con el mundo, sólo a través de lo que tecleas, pero no es una interacción directa.

¿Podría decirse, entonces, que la inteligencia artificial no es demasiado inteligente, ahora mismo?

Es una inteligencia muy específica, son cosas muy superespecializadas y hace muy bien las tareas para las que alguien la ha preparado, pero por iniciativa propia no hace nada. El coche autónomo es el caso más típico. Hay programadores que programan la tarea directamente o que hacen un software que aprende a realizar determinada tarea a partir de ejemplos y observaciones, pero esto es muy complicado cuando la tarea tiene muchas variables o muchas casuísticas; y el mundo es muy imprevisible y no se pueden pensar a priori todas las situaciones que se podrían dar. Un software que hace esto, yo no lo considero inteligente, a menos que redefinamos el concepto de inteligencia y lo flexibilicemos mucho. La alternativa es programarlo para que aprenda cuando se encuentre con estas situaciones, y esto es muy lento. Con la IA se intenta dotar a las máquinas de alguna de las capacidades inteligentes que tenemos los humanos –como razonar, aprender, generalizar, adaptarse a una situación nueva, resolver un problema cuando éste se aleja de aquello que es lo normal, tomar decisiones ante incertidumbres…–, pero de momento no lo estamos llevando muy bien, y esto genera preguntas éticas importantes.

El sistema Lavender determinó como objetivos con alta probabilidad de pertenecer a Hamás a 3.700 personas que eran completamente inocentes

En este sentido, la UE aprobó recientemente una regulación sobre el uso ético de la IA. ¿Cree que ésta cumple con las expectativas y que tendrá una aplicación real y práctica?

Esta ley tiene muy buenas intenciones y apunta hacia el buen camino, pero no estará en vigor antes del 2026, porque debe pasar una serie de trámites dentro de Europa. Incluye progresos importantes para regular y proteger a la sociedad y para disminuir los posibles impactos negativos en la sociedad pero, en mi opinión, se queda corta. Por ejemplo, la ley ni siquiera menciona las armas letales autónomas… Estoy seguro de que se debe a que los lobbies y los estados que negocian con el mercado de las armas están totalmente en contra de que se prohíban y, para mí, esto desprestigia mucho la ley. Un ejemplo: el sistema Lavender, que decide qué objetivos debe atacar el ejército de Israel. Los mismos que desarrollaron este software admiten que tiene un 10% de errores, falsos positivos; es decir, que detecta como posible objetivo a alguien que no lo es en absoluto; cree que una persona pertenece a Hamás cuando no tiene nada que ver. El 10% de 37.000 (3.700 personas), que es la cantidad de objetivos que el sistema determinó que tenía una alta probabilidad de ser miembro de Hamás, fueron atacados siendo completamente inocentes. Este software lo ha hecho una empresa de Israel, pero podría haberse hecho en Europa y, con la entrada en vigor de esta ley (2026-2027), se podría hacer un Lavender 2 mientras éste se comercialice fuera de Europa. Esto es escandaloso. Otro tema con el que la ley se queda corta es en el reconocimiento facial. Este control masivo de la ciudadanía puede realizarse en la UE, a pesar de la ley, siempre que un juez lo autorice. Y, precisamente en Catalunya, sabemos muy bien lo que puede pasar con las decisiones de los jueces… yo lo habría prohibido en todas las circunstancias.

¿Ve factible, con el tiempo, acordar una ética global a nivel mundial sobre la IA?

Creo que es prácticamente imposible, porque lo que es ético para unos, quizás no lo sea para otros. Entre culturas distintas no existe una moral universal, y así difícilmente habrá una ética universal. Por lo que se refiere a la ley europea de inteligencia artificial parece que hay bastante aceptación entre la cultura europea. Pero, por ejemplo, en China aplicarán algo completamente diferente… Allí, quizás se acepte lo que aquí se considera no sólo no ético, sino incluso no legal en cuanto a privacidad de datos o al control de la ciudadanía.

Aquí tocaríamos de lleno el tema de la privacidad… ¿Qué ocurre con la privacidad de la gente en este mundo cada vez más digital?

Desde el momento en el que llevas un móvil en el bolsillo y haces búsquedas y compras por internet se pueden llegar a saber muchas cosas sobre ti, incluso algunas de muy íntimas. A pesar de intentar hacer lo que llamo “dieta digital”, como no autorizar y rechazar cookies… apenas tenemos privacidad, y corremos un peligro bastante preocupante. La privacidad pienso que, desgraciadamente, es una batalla perdida, y las generaciones más jóvenes son menos conscientes en este aspecto.

Desde el momento en que llevas un móvil en el bolsillo y haces búsquedas y compras por internet se pueden saber muchas cosas sobre ti. Apenas tenemos privacidad, y corremos un peligro preocupante

La IA también se aplica cada vez más a la asistencia a los humanos; los denominados altavoces inteligentes son un claro ejemplo de ello. Si hace quince años esto parecía imposible, ¿qué podemos esperar que revolucione nuestros hogares en quince años más?

Quince años son muchos. La línea de esta IA generativa, que es muy poco fiable, creo que tocará techo en breve si no se realizan cambios tecnológicos y científicos importantes. Tengo la sensación de que, dentro de 15 años o quizás antes, la IA que habrá será bastante diferente a la que hay ahora. Estos modelos de lenguaje tipo ChatGPT creo que tienen los días contados, y que la burbuja de estos sistemas está empezando a desinflarse; a las empresas que desarrollan estas técnicas les cuesta cada vez más encontrar financiación e inversores capaces de asumir riesgos importantes como éste… El futuro de la IA creo que será muy distinto al que hay ahora; habrá nuevas técnicas con elementos que facilitarán preservar la verdad a través de híbridos de lo que se está haciendo actualmente y las cosas que se hacían antes, pero mejoradas.

¿Hasta qué punto diría que la IA es fiable?

No lo es en absoluto, y el problema es que esta carencia de fiabilidad no se puede arreglar. Algunos dicen que la IA alucina. A mí no me gusta demasiado utilizar esta palabra, porque es como antropomorfizar la IA y yo lo evito, porque no estamos hablando de personas. Estas últimas tendencias de la IA son las que “alucinan” y cometen errores flagrantes; antes se utilizaban métodos muy distintos, que eran ‘preservadores de la verdad’ (truth preserving), basados en conceptos de la lógica matemática. Esta lógica se construye sobre el concepto de deducir verdades a partir de antecedentes verídicos, y dado que la base de todo eran razonamientos de verdades que conducían a otras verdades, no nos encontrábamos con los problemas que tenemos ahora: una IA que se basa en analizar grandes cantidades de datos (textos, fotos, vídeos,…), cientos de millones de datos, a niveles prácticamente astronómicos. Dado que detrás no hay un método que preserve la verdad nos puede decir cualquier animalada, porque simplemente genera texto calculando la probabilidad más alta de la siguiente palabra (qué palabra es más probable que siga a la secuencia de otras palabras), y esto hace inherentemente imposible que garantice la verdad. La primera versión del ChatGPT, por ejemplo, decía que yo ya había muerto, porque lo que hace esta IA son aproximaciones, y quizás estadísticamente mucha gente nacida alrededor de los años cincuenta ya ha muerto,… Después, puedes entrenar esta IA y corregir ese error, pero generará otros errores.

Entonces ¿qué beneficios aporta la IA a la sociedad actual?

En el ámbito en el que más se ven los beneficios de la IA es, sobre todo, en aplicaciones para la salud. Los sistemas de IA ayudan mucho a los médicos a tomar mejores decisiones. En diagnósticos por imagen existen cientos de ejemplos, porque el ojo humano ve a nivel muy global y, en cambio, la IA ve los píxeles de las imágenes, tiene un nivel de resolución muy, muy fino, y puede detectar determinados patrones de, por ejemplo, dónde hay un posible tumor que todavía es imperceptible para el ojo humano. En estos casos, las visiones con resoluciones diferentes se complementan. La IA es una muy buena herramienta para los médicos, es una amplificación de la capacidad del médico, porque incrementa mucho la precisión diagnóstica. La combinación del análisis de un médico con la ayuda de la IA da resultados brutales.

En el ámbito en el que más se ven los beneficios de la IA es, sobre todo, en aplicaciones para la salud

En el sector laboral, uno de los temores que más se ha extendido es que la inteligencia artificial podría ser el perfecto sustituto de miles de lugares de trabajo. ¿Cree que es un escenario posible?

Ya lo es, sin embargo, en este caso, la IA es sólo una etapa más de la automatización. La historia del mundo moderno pasa por la automatización, y esto conlleva transformaciones en el mercado laboral; hay gente que deja de hacer lo que hacía para realizar otras cosas. Pero casi siempre los sitios perdidos se compensan por nuevos puestos de trabajo. Con la informática también ocurrió. Ahora, con la IA, ¿qué puede ocurrir? Honestamente, nadie puede decir todavía si se crearán suficientes nuevos lugares de trabajo para compensar todos aquellos que se irán sustituyendo. Pero estoy convencido de que hay una serie de tareas que no podrán ser sustituidas, como las que requieren cierta destreza, porque las máquinas no son diestras en absoluto, y en muchos casos será necesaria igualmente una intervención humana.

¿Podría poner un ejemplo?

Aquí deberíamos concretar si estamos hablando de tareas o de puestos de trabajo completos, porque un mismo puesto de trabajo se compone de muchas tareas… Se podrán automatizar tareas de muchas posiciones, pero estoy convencido de que habrá otras muchas donde la IA no llegará y, por tanto, deberemos trabajar en equipo. Por ejemplo, el radiólogo no sólo mira radiografías, sino que hace otras muchas cosas a lo largo del día. En este caso, para observar si en la radiografía de unos pulmones existe o no la posibilidad de un tumor, la IA puede ser una ayuda excelente, pero sólo a la hora de observar la imagen; en todo el resto del proceso, como tener en cuenta el contexto, antecedentes, historial, valoraciones, literatura científica etc. será necesaria la intervención de un médico. Por tanto, la IA debe verse como una herramienta de ayuda. Para mí, el enfoque del impacto en el trabajo debe verse desde este punto de vista. Esto no significa que no haya un período transitorio problemático, porque será necesaria una adaptación y habrá que trabajar de manera distinta a como lo hacemos ahora.

Nadie puede decir todavía si se crearán suficientes nuevos puestos de trabajo para compensar todos aquellos que se irán sustituyendo

En cuanto al tan popular ChatGPT, hay un gran debate en el campo de la educación, donde existen grandes partidarios y detractores….

Yo estaría en contra de usar de forma estúpida el ChatGPT o la inteligencia artificial en general. Pero al ChatGPT le puedes dar la vuelta y utilizarlo como herramienta de ayuda para la enseñanza. Y hay gente que lo está haciendo. Nosotros hemos hablado con profesores sobre IA y educación y han salido cosas muy interesantes como, por ejemplo, encargar a los estudiantes que trabajen un tema –la caída del Imperio romano, Galileo o cualquier otro– utilizando el ChatGPT. Una vez tengan los resultados del ChatGPT se les pide que hagan un análisis crítico y que hagan fact-checking: de todo lo que ha generado la inteligencia artificial, qué es correcto, qué es incorrecto y por qué… Es un ejercicio muy bueno para el estudiante, además de instructivo y pedagógico, porque comprobarán, por experiencia directa, que el ChatGPT puede generar auténticas burradas. Por tanto, quizá ya no se fíen tanto. Además, habrán comprobado qué es cierto y qué es falso sobre un determinado tema y habrán tenido que buscar fuentes creíbles y fiables, y esto es una excusa para aprender.

En su caso, ¿ha utilizado en algún momento el ChatGPT para escribir parte de su libro?

Para nada. De hecho, cuando empecé a escribirlo aún no existía. Cossetània me propuso hacer el libro en el 2021… En este sentido, creo que si todos nos acostumbramos a tener una primera versión con el ChatGPT y que ya corregiremos, acabaremos siendo incapaces de empezar un escrito desde cero. La creatividad se verá muy afectada. Es que no nos damos cuenta del impacto que puede tener, incluso a nivel cognitivo… Y la cultura del esfuerzo también se verá afectada… Para mí, se trata de una herramienta que, puesto en una balanza lo positivo y lo negativo, en estos momentos pesa más lo negativo; el balance global no me gusta, pero eso no quiere decir que no tenga cosas positivas.

Al ChatGPT le puedes dar la vuelta y utilizarlo como herramienta de ayuda para la enseñanza

Otro sector que también impacta en la IA es el medioambiental. ¿Su desarrollo es sostenible a largo plazo?

Con la tecnología que tenemos ahora, basada en silicio, seguro que no. El GPT-4, por ejemplo, requiere de una cantidad brutal de consumo eléctrico: mil millones de kilovatios, que son un teravatio, y esto no es para nada sostenible. También las emisiones de los semiconductores, las GPUs, que entrenan al GPT-4, consumen una gran cantidad de energía. Con este aumento de las emisiones se prevé que la demanda de electricidad del sector de la tecnología mundial crezca más de un 60% entre 2020 y 2030. Para mí, este reto del consumo energético quizás acabe siendo uno de los factores limitadores más importantes del desarrollo de esta inteligencia artificial.