Somos una Fundación que ejercemos el periodismo en abierto, sin muros de pago. Pero no podemos hacerlo solos, como explicamos en este editorial.

¡Clica aquí y ayúdanos!

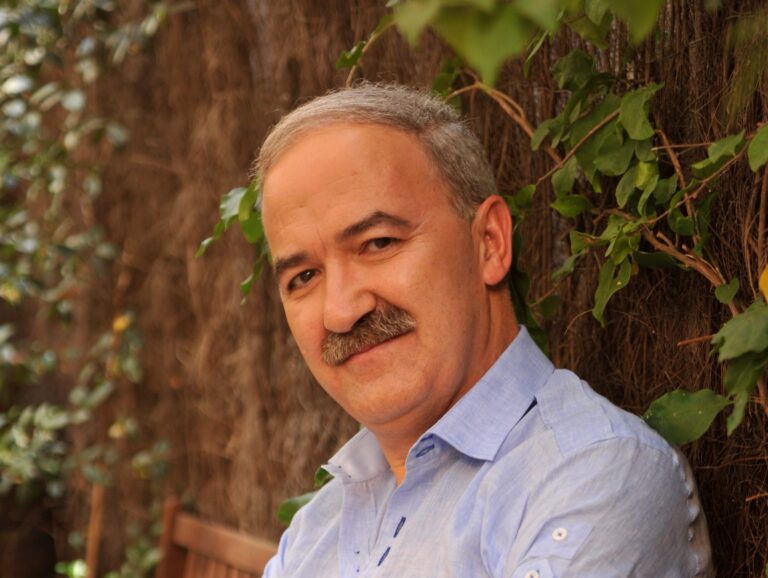

Con 18 años de experiencia en el mundo de la evaluación externa a sus espaldas, Francisco Luna sabe de lo que habla. Es sincero y las defiende en medio de un mar de críticas (“sería hipócrita decir que son inútiles cuando he vivido de ellas”), pero también rechaza cómo se están planteando. Al menos en determinadas formas. Las ideas fuerza del discurso de Luna respecto a las evaluaciones pueden resumirse en dos: son útiles, aunque no deben ser el único elemento que considerar cuando se evalúen sistemas educativos, solo uno más, y lo importante es preguntarse para qué se hacen y actuar en consecuencia.

Para fijar el marco de la entrevista, ¿cuál es su opinión general de las evaluaciones externas?

Desde mi posición de haber vivido de ellas en los últimos 18 años sería hipócrita decir que son inútiles. Las evaluaciones estandarizadas externas son un mecanismo potente, con posibilidades de describir suficientemente bien los sistemas educativos. Si hacemos las cosas bien, con criterios claros y sin cometer algunos errores que se están cometiendo, nos permiten disponer de información muy interesante. Son solo una fotografía, a veces borrosa, que tiene una gran capacidad para describir pero limitada para explicar por qué ocurren las cosas. No pueden ser el eje central de los sistemas porque es un error. Miden lo que pueden medir.

¿Qué no miden?

Hay aspectos del currículum y del aprendizaje que no somos capaces de medir. No podemos medir la capacidad de autonomía o iniciativa personal que tiene el alumno. Tenemos dificultades para medir la competencia de un alumno para participar en un equipo de trabajo, y no te hablo de las relacionadas con el mundo artístico, motriz, etc. Estas evaluaciones tienen una experiencia y un aval técnico muy grandes en determinados ámbitos (por ejemplo, sabemos hacer la medición de la competencia lingüísitica, matemática o científica), pero hay dificultades para medir otros como aprender a aprender o las competencias sociales. Si situamos las evaluaciones en su contexto, situamos para qué las queremos y le damos su espacio —pero no más— es un instrumento interesante y necesario.

¿Qué errores estamos cometiendo?

Desde los 90 todas las evaluaciones se han convertido en un eje central del cambio y la reforma de los sistemas educativos. ¿Qué ha hecho este movimiento general de implantación de las evaluaciones? Inocularnos una serie de parámetros que se utilizan a nivel mundial como eje de los cambios. Ahora no hay nadie que quiera hacer una reforma sin mencionar la excelencia, la evaluación, estandarización, rendición de cuentas, rankings, libre elección… Esta es la terminología que nos han inoculado. Pero todo esto nos lleva a un determinado sistema educativo. Por ejemplo, en las conclusiones de PISA se indica que una mayor autonomía escolar da mejores resultados si se relaciona con una buena rendición de cuentas. Para eso son necesarias unas evaluaciones estandarizadas que den datos y responsabilicen a los centros del proceso de aprendizaje. Esto es culpabilizar y poner en manos de los centros toda la responsabilidad de lo que ocurre. Los profesores tienen mucha responsabilidad en lo que ocurre, pero no toda. Este es un problema fuerte: meternos en una dinámica de evaluaciones que convierta todo el sistema en una responsabilidad de los centros.

Otro problema es que las evaluaciones estandarizadas externas cuestan mucho dinero si se quieren hacer con garantías. En España hay 17 comunidades autónomas. ¿Las 17 nos vamos a meter a hacer una evaluación con garantías? Estamos haciendo pruebas con garantías técnicas mediocres y la comparabilidad de resultados entre unas y otras deja que desear. Otro problema con estas evaluaciones tiene que ver con darles mayor importancia de la que tienen. Hasta 2015 en PISA teníamos unos resultados muy buenos. Con los resultados de 2012 en País Vasco estábamos por encima de las medias internacionales. Salían artículos de prensa que se preguntaban por qué Euskadi no se tomaba como referencia a nivel estatal de cómo debería ser un sistema educativo. Cuando recibimos los resultados de PISA 2015 se nos hundió el mundo. Un resultado en un año concreto, ¿puede poner en cuestión todo un sistema educativo? Si caemos en los rankings podemos tomar medidas erróneas.

¿Qué debe tener una buena prueba de evaluación?

El problema que tenemos es que las evaluaciones se han convertido en una línea educativa. Tenemos la dificultad de que los medios de comunicación se fijan solo en la posición. Pero lo importante es la distancia. Si tenemos tres alumnos con un 9, un 5 y un 3 la posición 1, 2 o 3 es importante. Pero si tenemos esa misma posición con esos mismos alumnos con un 7,5, un 6,5 y un 5,9 es menos importante la posición porque la distancia es menor. Tenemos que darle a la evaluación el espacio que tiene. Es imprescindible, sin duda. Pero estas evaluaciones cuantitativas son solo un primer paso. Importante, sustancial, necesario, pero un primer paso. Si anulamos el resto de los pasos lo que hacemos es darle una función que no tiene. Estas evaluciones explican una parte de la realidad, pongamos el 50% o 60% de la diferencia de resultados entre países. Pero hay una parte que no podemos describir. Si estas evaluaciones no se ligan a los siguientes pasos (como hacer investigación educativa para explicarnos por qué ocurren las cosas), no estaremos llegando hasta el fondo de los problemas. Si los datos no los contextualizamos a la situación política, social o cultural, estaremos tomando decisiones equivocadas. Si pensamos que las evaluaciones tienen que generar propuestas de arriba hacia abajo no nos daremos cuenta de que los sistemas educativos no se cambian así. Sabemos que los planes de formación, mejora y reforma institucionales no sirven para nada. Estas evaluaciones de centro aportan información para que puedan mejorar. Pero la tendencia de los políticos cuando se encuentran un mal resultado es buscar una solución global para todo el sistema. No funciona. El curso pasado una analista senior de la OCDE explicaba que en los últimos siete años se han hecho 430 reformas educativas a partir de los resultados de PISA en más de 30 países, pero no ofrecen resultados. Hay una tendencia a que las reformas no lleguen al aula, se quedan a nivel de centro, y si algo sabemos es que el cambio se hace en el aula. Otra razón por la que estas reformas no dieron resultado es porque la formación de los docentes, necesaria para ese cambio, había sido insuficiente o superficial. A veces nos conformamos con cursos de unas horas y a partir de ahí queremos poner en marcha un plan para desarrollar las competencias básicas en el currículum. Tenemos que darle un papel a las evaluaciones. ¿Para qué las queremos? Es un debate. Es distinto si queremos una evaluación con el objetivo de la equidad o la competitividad. Es distinto si los resultados son internos para que los centros hagan planes de reformas o públicos para que los padres elijan centro.

¿Y para qué se están haciendo las evaluaciones en España?

El desarrollo de la evaluación en el sistema español es joven, pero ya ha pasado por varias fases. Hubo una primera en la que las comunidades participábamos de lo que hacía el Instituto Nacional de Evaluación. Con la LOE surgieron las evaluaciones de diagnóstico, competencia de cada comunidad, que tuvo que crear sus propias evaluaciones. La mayoría hizo un modelo, para mí precario, que es una evaluación en la que la administración elabora las pruebas, las manda al centro, que las aplica y corrige y las mete en el sistema. Algunas, como Cataluña o La Rioja, lo hicieron con otro modelo: la administración creaba las pruebas, pero eran profesores de otro centro los que evaluaban a los alumnos, al contrario que en el anterior modelo. Hay una tercera, que es la que hacemos en Euskadi, donde hacemos las pruebas y aplicadores y correctores externos las aplican. Hubo incluso la evaluación general de diagnóstico, que era una evaluación conjunta de todas las comunidades. Por primera vez hubo una prueba aplicada por todas las comunidades para todo el Estado. Era una metodología que estaba empezando a funcionar. En ese momento vino la LOMCE, que transformó todo el debate que estaba más o menos asumido sobre qué eran las evaluaciones externas (tenían carácter interno para los centros, formativo e informativo para las familias). La LOMCE lo cambió: metió las reválidas, las convirtió en una prueba para pasar de una etapa a otra, un filtro, etc. y todo esto ha destrozado las evaluaciones y ahora hay una cierta crisis de la evaluación pese a que no tenemos la experiencia suficiente para tener esta crisis. Lo que se está haciendo son los últimos coletazos de una fenecida ley. Cada comunidad autónoma está haciendo las cosas de una manera, cuando se pensaba que se iba a unificar. En el tema de la evaluación, la LOMCE ha sido un obstáculo en el camino que se había emprendido.

¿Está justificada entonces la polémica y el rechazo a las pruebas?

Estas evaluaciones son técnicamente potentes, pero tienen limitaciones. Una muy fuerte es cuando se llega al nivel de resultados de alumnos. En ocasiones, los que estamos en este campo actuamos con una cierta arrogancia técnica, pensando que nuestros instrumentos son capaces de describir mejor la situación de aprendizaje de un centro que las pruebas que hace el propio centro. Y esta arrogancia está debajo de la decisión de que estas evaluaciones fueran condicionantes para superar la prueba. No hay ningún país europeo que haga las evaluaciones externas de esta manera. Sigo pensando que son útiles, pero si competimos con la evaluación académica, siempre saldrá perdiendo una evaluación externa. Nunca deben competir, son cosas distintas. Las evaluaciones externas son una foto, y en un centro tienen un vídeo. No puedes competir salvo que tengas la osadía de decir que no confías en lo que dice el centro o el profesorado con la información que recogen durante todo el curso. En este momento, las evaluaciones externas de la LOMCE son una especie de arrastre sin demasiado sentido que no llevan a nada.

Algunas cuestiones más específicas. Los profesores se quejan de que tengan que ser otros docentes quienes las hagan porque los chicos, dicen, se ponen más nerviosos. ¿Es apropiado?

Es cierto que hay quejas en ese sentido, pero está muy relacionado con dónde sitúas la evaluación. Si lo haces como referencia única de un centro, entonces es normal que se pongan nerviosos, porque les estás dando una única fotografía que tienen que trasladar a las familias. Pero si les garantizas que es una información interna, sin rankings ni difusión de esa información, y que tienen autonomía para actuar a partir de esos resultados, no tiene por qué ser así. Si es una información complementaria periódica para compararte con otros centros y puedes analizar qué cambiar, estas evaluaciones aportan información y no tienen por qué ponerte demasiado nervioso porque no tienen consecuencias directas ni en el sueldo ni en los resultados académicos; es una información más para la toma de decisiones.

Cuando nosotros empezamos la evaluación teníamos quejas de este tipo, una reacción muy de preservar a los alumnos de cualquier ataque externo de un enemigo desconocido. Luego se dieron cuenta de que no pasaba nada de esto. Nos pasó que los centros les daba más fiablilidad que lo hiciéramos nosotros que ellos. De hecho, en algunas comunidades que lo hacían internamente dudaban de que los datos que se daban a partir de la corrección interna fueran comparables. Pero somos una intrusión en la vida normal del centro, intentamos hacerlo con las mayores garantías posibles, molestar lo menos posible. Aunque el observador siempre transforma el objeto observado. Por eso lo importante no es un dato puntual en un año concreto en una competencia específica, sino la tendencia. Indica mucho más.

¿Pueden hacerse a cualquier edad o hay un mínimo que no debería sobrepasarse?

En sentido estricto no, únicamente hay que adaptar los tiempos, los instrumentos, el contexto, la relación con el alumno. Se puede hacer desde infantil hasta bachillerato. El tipo más habitual para evaluaciones externas es a partir de mitad de la educación primaria en casi todos los países. En primaria la mayoría de los países tienen pocas evaluaciones externas. Son algo más frecuentes en secundaria y prácticamente universales en la etapa preuniversitaria. En estos momentos se está trabajando en el diseño universal de las evaluaciones. Se está pensando qué elementos tienen que tener estas evaluaciones para que no sean un obstáculo para percibir las competencias reales que tienen los alumnos y no afecten a las dinámicas de los centros. ¿Cuáles son los aspectos técnicos que una evaluación y un instrumento como las evaluaciones externas tiene que tener en cuenta para que sean equitativas? A veces las evaluaciones externas no recogen la diversidad de los centros. A veces pelean contra algunos enemigos. Las diagnósticas (sin consecuencias para los alumnos) son de alguna manera unas pruebas de bajo riesgo, no hay nada en juego para los alumnos. Pero hay una serie de factores culturales relacionados con el esfuerzo y la motivación que son importantes para estas pruebas. Las investigaciones dicen que una parte importante de la diferencia entre países vienen no tanto por la diferencia de competencias sino por la motivación para hacer estas pruebas. En España, los alumnos que hacen PISA empiezan muy bien, si tomáramos como referencia los primeros ítems el resultado sería muy alto. Pero, ¿qué ocurre? Que el decaímiento, el cansancio, baja con intensidad en España, mientras en otros países afecta menos. Este es un enemigo de esta evaluación. No te juegas nada, pero lo que contestas como alumno va a dar la fotografía del estado del sistema educativo y casi de un país. Hay que hacer mucho esfuerzo para motivar a los alumnos.